Bang Jonie ~ Dalam artikel SEO Blog kali ini saya ingin mengajak Anda mengenal lebih jauh apa itu file robots.txt, bagaimana cara menggunakan file robot, yang juga merupakan bagian dari teknik SEI Blog.

Robots.txt adalah file teks sederhana berguna memberitahu robot mesin pencari seperti Googlebot tentang apa saja yang boleh dan tidak boleh dirayapi (crawling).

Allow full access

Block all access

Block specific file

Block folder

Tip: Silakan lihat Pedoman Webmaster Google.

Robots.txt adalah file teks sederhana berguna memberitahu robot mesin pencari seperti Googlebot tentang apa saja yang boleh dan tidak boleh dirayapi (crawling).

|

| Googlebot Img Src: zanet.co.uk |

Contoh setup dasar robots.txt

Berikut adalah contoh setup dasar file robots.txt serta penjelasannya:Allow full access

User-agent: *

Disallow:

Block all access

User-agent: *

Disallow: /

Block specific file

User-agent: *

Disallow: /file.html

Block folder

User-agent: *

Disallow: /folder/

Mengapa harus memahami robots.txt

- Penggunaan robots.txt yang tidak tepat dapat menurunkan peringkat web di mesin pencari

- Fie robots.txt berfungsi mengontrol bagaimana spider web milik search engine melihat dan berinteraksi dengan web

- File robots.txt juga tercantum dalam beberapa pedoman Google

- File robots.txt berinteraksi dengan bot mesin pencari, merupakan bagian mendasar dari cara kerja mesin telusur

Tip: Silakan lihat Pedoman Webmaster Google.

Spider web Search Engine

Yang pertama dicari robot mesin pencari ketika mengunjungi sebuah situs adalah file robots.txt. Sebab dalam file robots.txt ini terkandung informasi apakah bot mesin pencari memiliki izin mengakses halaman atau file dalam situs tersebut?Melalui file robots.txt inilah sebagai pemilik situs atau webmaster dapat menentukan dan memberi petunjuk kepada mesin pencari apa saja yang boleh maupun tidak boleh diakses

Lihat Memahami file robots.txt.

Prioritas utuk web

Ada tiga hal penting harus dilakukan oleh pemilik situs atau webmaster untuk bot mesin pencari:- Pastikan bahwa Anda memiliki file robots.txt

- Jika ada pastikan bahwa file robots.txt tidak merugikan situs karena kesalahan penulisan dapat menyebabkan situs diblokir oleh mesin pencari.

- Pastikan bahwa Anda memang benar-benar membutuhkan file robots.txt

1. Pastikan Anda memiliki file robots.txt

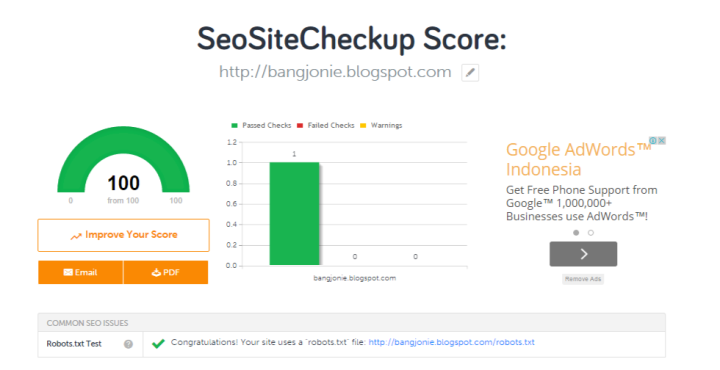

Anda dapat mengetahui apakah Blog Anda mengandung robots.txt dengan menggunakan tool Robots.txt Test.Cara penggunaannya cukup mudah tinggal memasukkan alamat sebuah situs web lalu klik Checkup. Hasil checkup tersebut akan menghasilkan sebuah url seperti terlihat berikut ini:

www.situsanda.com/robots.txtGambar berikut menunjukkan situs memiliki file robots.txt

|

| Tool untuk memastikan sebuah situs memiliki file robots.txt |

Pastikan fie robots.txt tidak memblokir file-file penting.

Anda dapat menggunakan Tool SEO Auditor, untuk mengetahui apakah ada file yang dibutuhkan Google sedang diblokir oleh robots.txtJika memiliki akun di Google Webmaster Anda dapat menggunakan Google search console guna menguji file robots.txt. Petunjuk penggunaannya dapat dilihat disini (tool ini tidak dapat dilihat secara publik, dibutuhkan login ke system).

Untuk memahami sepenuhnya jika file robots.txt tidak memblokir segala sesuatu yang tidak ingin Anda blokir, maka dari itu disarankan memahami dengan baik fungsi dan kegunaan file robots.txt. Mari kita lihat penjelasan singkat berikut ini:

Apakah Anda butuh file robots.txt

Mungkin saja Anda tidak membutuhkan file robots.txt. Untuk lebih jelasnya lihat penjelasan berikut ini.Mengapa butuh file robots.txt:

- Tidak ingin diakses oleh mesin pencari

- Menggunakan link berbayar atau iklan yang memerlukan petunjuk khusus untuk robot

- Ingin agar mesin mencari dapat sepenuhnya memahami cara akses ke situs Anda.

- Sedang mengembangkan situs secara live, dan tidak ingin mesin pencari mengakses dan mengindeks situs

- Dalam situasi tertentu Anda ingin memahami dan menyelaraskan situs agar sesuai denagn panduan dari Google

- Membutuhkan beberapa atau semua item seperti dijelaskan di atas, tetapi tidak memiliki akses penuh ke server web untuk kebutuhan konfigurasi

Alasan tidak membutuhkan file robots.txt:

- Tidak memiliki file yang perlu diblokir dari mesin pencari

- Tidak dalam salah satu situasi tercantum di atas untuk memiliki file robots.txt

Note Sebuah situs tidak akan bermasalah jika tidak memiliki file robots.txt kecuali Jingling :)

Jika tidak memiliki file robots.txt maka robot mesin pencari seperti Googlebot akan memiliki akses penuh ke situs Anda. Ini adalah cara normal, sederhana dan sangat umum.

Cara membuat file robots.txt

Jika dapat mengetik dan mengetahui cara copy dan paste, berarti Anda juga dapat membuat file robots.txt.

Karena robots.txt hanyalah berupa file teks biasa, berarti Anda dapat menggunakan notepad atau editor teks lainnya untuk membuat file robots.txt, bahkan dengan editor teks web seperti Blogger atau editor Wordpress.

Apa yang dapat dilakukan file robots.txt ?

File robots akan bekerja sesuai dengan apa yang diinginkan.Mengizinkan semua bot untuk mengakses semua file

User-agent: *

Disallow:

Blokir semua bot untuk mengakses semua file

User-agent: *

Disallow: /

Semua instruksi yang dimasukkan ke dalam file robots.txt menghasilkan salah satu fungsi dari tiga fungsi berikut:

Full Allow: mengizinkan semua konten untuk dijelajahi.

Full Disallow: tidak mengiznkan semua bot untuk menjelajahi semua konten.

Conditional Allow: instruksi yang dimasukkan dalam file robots.txt akan membolehkan akses peryapan hanya untuk konten tertentu.

Mari kita lihat secara detail masing-masing fungsi diatas:

Full Allow: semua konten dapat diindeks

Hampir semua orang ingin bot mesin pencari seperti Googlebot untuk mengunjungi segala sesuatu di situs web mereka. Jika hal ini terjadi pada situs Anda, dan ingin agar robot mengindeks semua bagian dari situs, ada tiga opsi dapat dilakukan agar robot mesin pencari tahu bahwa mereka dipersilakan mengindeks situs Anda.1) tidak menggunakan file robots.txt

Berikut merupakan hasil atau efek yang akan terjadi jika blog tidak memiliki file robots.txtHal pertama dicari Robot ketika mengunjungi situs adalah file robots.txt. Jika situs tidak mengandung file robots.txt maka bot mesin pencari dengan bebas merayapi semua konten dan halaman blog. Kira-kira seperti itulah logika robot mesin pencari memahami sebuah situs yang tidak ada file robots.txt.

2) membuat sebuah file kosong dan memberi nama robots.txt

Jika situs web Anda memiliki file robots.txt kosong di dalamnya maka inilah yang terjadi...Robot datang mengunjungi situs Anda. Hal pertama yang dicari adalah file robots.txt. Ketika bot melihat file robots.txt kosong maka bot bebas merayapi seluruh halaman blog dan konten Anda. Seperti itulah logika bot memahami arti perintah file robots.txt yang kosong.

3) membuat sebuah file bernama robots.txt lalu menulis dua baris kode berikut di dalamnya...

User-agent: *

Disallow:

Jika situs memiliki robots.txt dengan instruksi seperti diatas di dalamnya maka inilah yang akan terjadi...

Robot seperti Googlebot datang mengunjungi situs Anda. Hal pertama yang dicari adalah file robots.txt. Ketika bot menemukan file robots.txt lalu bot membacanya. Membaca baris pertama. Kemudian membaca baris kedua. Bot kemudian merasa bebas merayapi seluruh halaman dan konten blog Anda karena seperti inilah apa yang diinstruksikan dalam file robots.txt.

Full Disallow: semua konten tidak boleh diindeks

Warning: Ini berarti bahwa Google dan mesin pencari lainnya tidak akan mengindeks atau merayapi halaman web Anda.

Untuk memblokir semua spider search engine utama dari situs Anda, Anda harus menulis perintah ini dalam file robots.txt Anda:

User-agent: *

Disallow: /

Penggunaan perintah robot diatas tidak dianjurkan karena akan mengakibatkan halaman web Anda tidak akan diindeks oleh mesin pencari.

Memahami arti perintah file robots.txt

Berikut penjelasan arti perintah file robots.txtUser-agent

User-agent"User-agent" Digunakan untuk menentukan robot mesin pencari tertentu diizinkan. Ada dua cara penggunaan perintah ini.

Jika ingin agar semua robot mesin pencari dapat mengakses situs Anda, letakkan sebuah tanda "*" setelah User-Agent: seperti terlihat berikut ini:

User-agent: *Perintah diatas akan mengizinkan semua robot mesin pencari menjelajah situs Anda.

Jika hanya mesin pencari tertentu saja misalnya Googlebot yang dapat mengindeks situs Anda gunakan perintah seperti berikut:

User-agent: GooglebotPerintah dalam file robots diatas hanya mengizinkan robot Google saja yang boleh mengindeks situs Anda.

Disallow

Perintah "Disallow" ada untuk memberitahu robot atau folder apa saja yang tidak boleh diindeks. Ini berarti bahwa jika, sebagai contoh Anda tidak ingin foto pada situs Anda diindeks di mesin pencari maka Anda dapat menempatkan foto-foto ke dalam satu folder dan memblokir folder tersebut agar tidak diindesk mesin mesin pencari.

Katakanlah misalnya Anda telah menempatkan semua foto-foto dalam sebuah folder bernama "photos". Dan Anda ingin memberitahu robot agar tidak mengindeks folder itu.

Berikut isi file robots.txt Anda yang sesuai dengan skenario diatas:User-agent: *Dua baris teks dalam file robots.txt Anda diatas akan membuat robot tidak akan mengindeks folder photos ketika mengunjungi situs Anda.

Disallow: /photos

"User-agent:* maksudnya adalah "berlaku kepada semua robot mesin pencari". Sementara maksud perintah Disallow: /photos adalah "jangan indeks folder photos"Perintah khusus Googlebot

Robot yang digunakan Google untuk mengindeks mesin pencari mereka disebut Googlebot. Googlebot memahami beberapa perintah file robots.txt lebih banyak ketimbang robot mesin pencari lainnya.

Selain "User-name" dan "Disallow" Googlebot juga menggunakan instruksi Allow.

Allow

AllowPerintah "Allow:" digunakan untuk memberitahu sebuah robot tentang folder atau file apa saja yang boleh diindeks dimana tidak dbolehkan oleh perintah sebelumnya.

Untuk menggambarkan hal ini, mari kita ambil dari contoh diatas yang tidak membolehkan robot mengindeks folder photos sebgai berikut:

User-agent: *

Disallow: /photos

Sekarang katakanlah ada file dalam folder photos dengan nama mobilku.jpg yang Anda inginkan agar dirayapi oleh Googlebot. Gunakan perintah "Allow:" sebagai berikut

User-agent: *Perintah diatas akan memberitahu robot mesin pencari agar mengindeks file mobilu.jpg yang ada dalam folder photos walau folder photos sudah diblokir oleh perintah Disallow diatas.

Disallow: /photos

Allow: /photos/mycar.jpg

Uji file robots.txt

Untuk mengetahui konten apa saja diblokir oleh robots.txt, dapat dilakukan dengan menggunakan tool SEO online ini, akan memberitahu jika ada file penting yang dibutuhkan Google sedang diblokir.

Kesimpulan dan saran:

- Jika menggunakan file robots.txt, pastikan file robots.txt tersebut digunakan dengan benar

- File robots.txt yang salah dapat mencegah Googlebot mengindeks halaman blog

- Pastikan tidak memblokir halaman yang memiliki nilai peringkat di halaman hasil pencarian Google